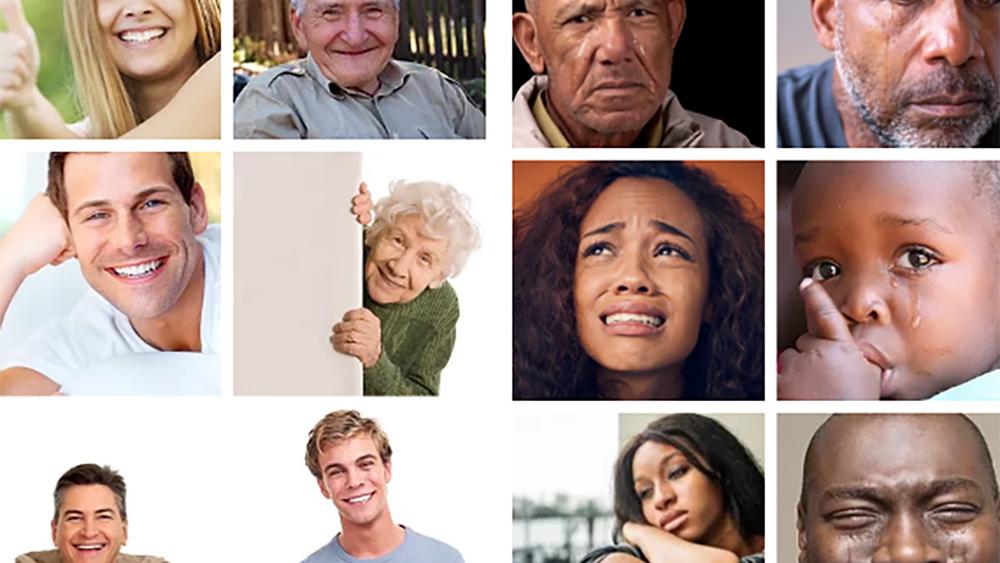

Onderzoekers van Penn State University en Oregon State University ontdekten dat gebruikers een systematische bias in de trainingsgegevens van kunstmatige intelligentie (AI) nauwelijks opmerken. In hun experimenten bleek dat wanneer de datasets alleen witte gezichten toonden voor “gelukkige” emoties en zwarte gezichten voor “verdrietige”, de proefpersonen zelden bewust werden van deze ongelijkheid.

|

Most users cannot identify AI bias, even in training data | Penn State UniversityWhen recognizing faces and emotions, artificial intelligence (AI) can be biased, like classifying white people as happier than people from other racial backgrounds. This happens because the data used to train the AI contained a disproportionate number of happy white faces, leading it to correlate race with emotional expression |

De studie in vogelvlucht

De wetenschappers creëerden twaalf varianten van een prototype AI-systeem dat gezichtsuitdrukkingen moest herkennen. In totaal namen 769 deelnemers deel aan drie experimenten waarin diverse scenario’s werden gepresenteerd:

- In één scenario werd bijvoorbeeld uitsluitend witte gezichten gebruikt voor blije emoties en uitsluitend zwarte gezichten voor verdrietige.

- In een ander scenario werden alleen gezichten van witte mensen gebruikt — ongeacht emotie.

- In het derde scenario werden meerdere condities gepresenteerd: bijvoorbeeld blije zwarte gezichten/somber witte gezichten, of helemaal gemengd, om te testen of de deelnemers de koppeling tussen etniciteit en emotie zouden doorzien.

De centrale vraag: kunnen gewone gebruikers (niet-experts) zien dat de trainingsdata voor het AI-systeem scheef waren samengesteld en dat dat de latere prestaties beïnvloedde?

Wat de resultaten onthulden

- Het merendeel van de deelnemers vond geen aanwijzingen dat het systeem ongelijk behandeld werd op basis van ras of etniciteit.

- Alleen in de laatste variant, waar zowel witte als zwarte gezichten werden getoond én de bias relatief duidelijk werd, waren zwarte proefpersonen meer geneigd om iets op te merken — vooral wanneer hun eigen groep vaker negatief werd afgebeeld.

- Zoals professor S. Shyam Sundar zegt: “AI lijkt geleerd te hebben dat ras een belangrijke criterium is voor het bepalen of een gezicht gelukkig of verdrietig is — ook al bedoelen we dat helemaal niet.”

Waarom dit belangrijk is

Deze bevinding onderstreept een aantal fundamentele aandachtspunten:

- Wanneer trainingsdata onnauwkeurig of scheef zijn samengesteld (bijvoorbeeld onder- of over-representatie van bepaalde groepen) kan het AI-systeem onbedoeld discriminerende correlaties leren.

- Niet alleen technici, maar ook gewone gebruikers gaan uit van neutraliteit van AI — terwijl de technologie óók gekleurd kan zijn door de data waarop hij is getraind. Sundar merkte op: “Mensen vertrouwen vaak dat AI neutraal is, ook wanneer het dat niet is.”

- Het feit dat gebruikers de bias niet herkennen betekent dat kritisch bewustzijn – zowel bij makers als bij gebruikers van AI-systemen — sterk vergroot moet worden.

- Voor beleidsmakers, ontwerpers van AI-systemen en het grote publiek is dit een duidelijke waarschuwing: diverse, representatieve datasets en communicatie over de beperkingen van AI zijn cruciaal.

Wat kunnen we eruit leren?

- Datasamenstelling telt: Zorg ervoor dat bij het bouwen van AI-systemen verschillende groepen adequaat vertegenwoordigd zijn — anders leert het systeem onbedoelde verbanden.

- Gebruikerseducatie: Het publiek moet beter worden geïnformeerd over hoe AI werkt en welke valkuilen er zijn — enkel vertrouwen op resultaten is onvoldoende.

- Rapportage en transparantie: Ontwikkelaars van AI-modellen zouden openheid moeten betrachten over de samenstelling van de trainingsdata en de mogelijke bias.

- Toekomstig onderzoek: De auteurs willen verder onderzoeken hoe bias effectief gecommuniceerd kan worden naar gebruikers, ontwikkelaars en beleidsmakers — en hoe media- en AI-geletterdheid kan helpen.

De studie laat zien dat zelfs wanneer de aanwijzingen van bias voor het oog liggen — zoals een systematische koppeling tussen ras en emotie in gezichtsdata — veel gebruikers dit niet opmerken. Dat is zorgwekkend omdat het betekent dat discriminerende systemen ongemerkt kunnen functioneren. Het is dus tijd voor een bredere dialoog over verantwoordelijkheid, ontwerp en gebruik van AI.