Dankzij nieuwe zelforganiserende AI-agenten verandert data-labelling van een arbeidsintensieve klus in een grotendeels geautomatiseerd proces. Wat betekent dat voor de toekomst van kunstmatige intelligentie én de mensen erachter?

Een stille revolutie in de wereld van AI-training

Data is het kloppend hart van kunstmatige intelligentie. Zonder grote hoeveelheden gelabelde gegevens kunnen AI-modellen simpelweg niet leren. Tot nu toe betekende dat een enorme afhankelijkheid van menselijke labelaars die miljoenen afbeeldingen, teksten of video’s handmatig voorzien van beschrijvingen en tags. Maar daar komt snel verandering in.

Onderzoekers van het Allen Institute for AI hebben een systeem ontwikkeld waarbij AI-agenten zélf data labelen — en dat op een manier die schaalbaar, efficiënt en verrassend nauwkeurig is. Deze "self-improving" aanpak kan de manier waarop we AI trainen radicaal veranderen.

Zelforganiserende agenten: leren zonder mensenhanden

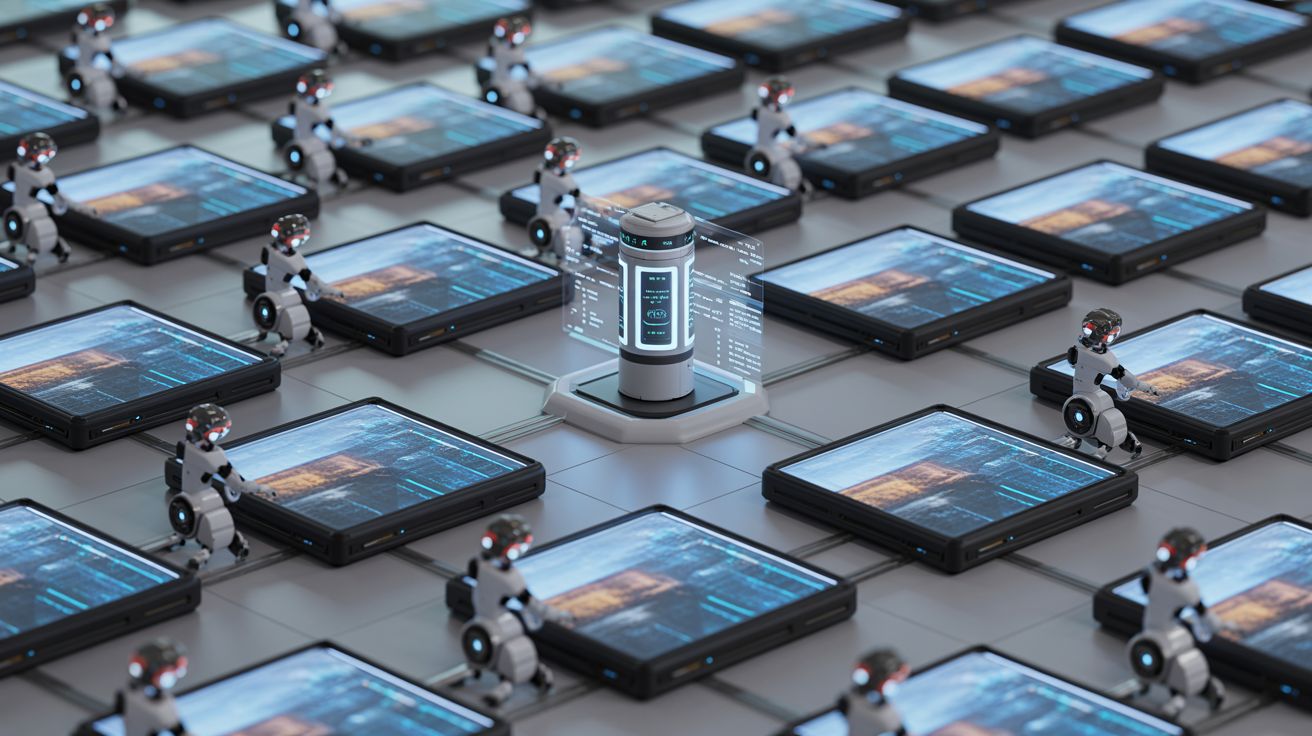

In het project, dat de naam LILA draagt (Language-Image Learning Agents), worden honderden kleine AI-agenten aangestuurd door een centrale ‘coördinator’. Elk van deze agenten bekijkt en labelt beelden, en past zijn gedrag aan op basis van feedback van de groep.

Deze opzet is geïnspireerd door zwermintelligentie: het principe dat een groep eenvoudige wezens, zoals mieren of vogels, samen complexe taken kan uitvoeren zonder centraal gezag. In het geval van LILA gaat het echter niet om natuur, maar om AI's die met elkaar samenwerken om miljoenen datasets te voorzien van labels, van “kat” tot “parlementaire zitting”.

Weg met menselijke bias?

Een belangrijk voordeel van deze aanpak is het verminderen van menselijke fouten en vooroordelen. Mensen zijn immers niet altijd consistent of objectief in hun labeling. AI-agenten daarentegen kunnen dezelfde standaarden blijven hanteren en leren van hun fouten via feedback-loops.

Toch betekent dit niet dat menselijke input volledig verdwijnt. In de vroege fase van het proces helpen mensen nog met het valideren van de eerste labels. Daarna neemt het systeem het over, waarbij mensen eerder als controlepost dan als arbeiders fungeren.

De schaal van LILA: 50 miljoen labels in recordtijd

In minder dan drie weken labelden de LILA-agenten meer dan 50 miljoen beeld-tekst-paren. En opvallend: de kwaliteit van hun labeling bleek vergelijkbaar, soms zelfs beter, dan die van bestaande, door mensen samengestelde datasets zoals LAION.

LILA's flexibiliteit maakt het systeem bovendien geschikt voor uiteenlopende toepassingen. Zo kunnen de agenten makkelijk worden ingezet voor medische beeldherkenning, juridische documenten of zelfs multimodale datasets die beeld, geluid én tekst combineren.

Wat betekent dit voor de toekomst?

De inzet van zelflerende label-agenten luidt een nieuw tijdperk in voor AI-ontwikkeling. Niet alleen kunnen datasets sneller en goedkoper worden opgebouwd, het opent ook de deur naar een meer duurzame en inclusieve aanpak van AI-training.

Maar er rijzen ook ethische vragen. Wat gebeurt er als deze systemen zelf biases gaan ontwikkelen, zonder menselijke controle? En wat met de miljoenen mensen wereldwijd die vandaag hun brood verdienen als data-labelaars?

Volgens experts ligt de sleutel in menselijke supervisie op systeemniveau. Niet in elke labeltaak, maar wel in het ontwerp, de bijsturing en de kwaliteitscontrole van de AI-agenten. Net zoals een boer niet elke bij in de zwerm bestuurt, maar wel het ecosysteem in stand houdt.

Conclusie: AI voedt zichzelf, maar heeft nog wel een voederbak nodig

De belofte van systemen zoals LILA is groot: AI die zichzelf voedt met data, zichzelf corrigeert en leert in teamverband. De weg naar volledig autonome AI-training lijkt open te liggen. Maar net als bij elk ander systeem blijft menselijke waakzaamheid nodig.

Want wie de AI voedt, bepaalt ook uiteindelijk wat ze leert.

Why Did Meta Invest Billions in Scale AI?Meta's $14 billion investment in Scale AI highlights the crucial role of data labeling in refining AI models for real-world applications. |