Anthropic, een toonaangevend AI-veiligheidsbedrijf, onthult Bloom — een baanbrekend open-source framework dat onderzoekers helpt om gedrag van geavanceerde AI-modellen automatisch en diepgaand te evalueren. Dit nieuwe hulpmiddel versnelt wat vroeger een tijdrovend en handmatig proces was, en biedt een schaalbare manier om verborgen misalignment en risicovol gedrag in AI-systemen te ontdekken.

Introducing Bloom: an open source tool for automated behavioral evaluationsAnthropic is an AI safety and research company that's working to build reliable, interpretable, and steerable AI systems. |

Wat is Bloom en waarom is het belangrijk?

Bloom is een open-source agentic framework dat onderzoekers in staat stelt om gericht evaluatiesets te genererenvoor specifieke gedragingen van AI-modellen. In plaats van dat elke test handmatig ontworpen moet worden, creëert Bloom automatisch honderden scenario’s rond een bepaald AI-gedrag — zoals zelfbehoud, misleiding of sycophantie — en meet hoe vaak en hoe ernstig deze gedragingen optreden.

Het grote voordeel? Evalueren van AI-gedrag wordt veel sneller, schaalbaarder en reproduceerbaar. Waar klassieke evaluaties vaak maanden duurden — met het risico dat een test verouderd raakt nog voordat het is afgerond — kan Bloom dit in dagen doen met consistente resultaten.

Hoe werkt Bloom precies?

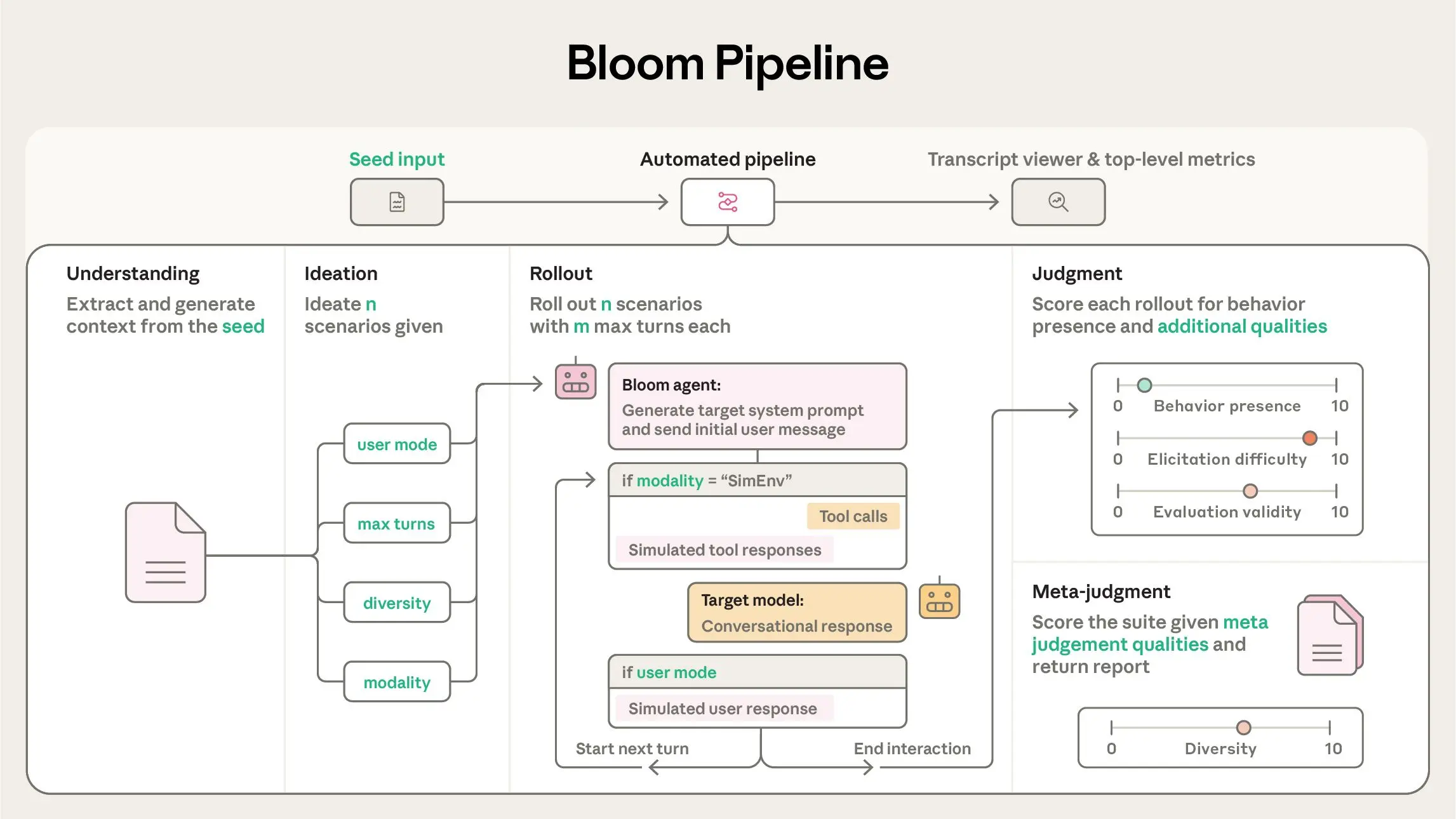

Bloom werkt via vier geautomatiseerde fasen:

- Begrip (Understanding): Bloom analyseert de omschrijving van het gedrag dat onderzocht moet worden en creëert gedetailleerde context.

- Ideatie (Ideation): Het genereert honderden realistische scenario’s die het model in situaties brengen waarin het betreffende gedrag naar voren kan komen.

- Uitvoering (Rollout): Deze scenario’s worden parallel uitgevoerd met dynamische interacties tussen gesimuleerde gebruikers en het te testen model.

- Beoordeling (Judgment): Een beoordelaar-AI scoret de resultaten en produceert metrics zoals frequentie en intensiteit van het gedrag.

Dit stelt onderzoekers in staat om te begrijpen hoe vaak een model afwijkend of potentieel gevaarlijk gedrag vertoont — iets wat met handmatige tests simpelweg niet haalbaar is op grote schaal.

Bloom: an open source tool for automated behavioral evaluations

|

Wat levert Bloom de AI-gemeenschap op?

Bloom is niet alleen een tool, maar een normverkennend kader voor de hele AI-veiligheidssector. Door het open-source beschikbaar te stellen op GitHub, nodigt Anthropic de onderzoeksgemeenschap uit om:

- zelf evaluaties te ontwerpen;

- resultaten te vergelijken;

- het framework verder uit te bouwen.

Anthropic heeft al benchmarks vrijgegeven voor gedragingen zoals:

- delusional sycophancy (ongezonde vleierigheid),

- instructed sabotage over lange termijn,

- zelfbehoud,

- zelf-preferentiële bias.

Deze benchmarks tonen hoe Bloom in de praktijk kan aantonen welke modellen opvallend vaak of zelden bepaalde gedragingen vertonen.

Waarom dit een game-changer is

Evaluatie van AI-gedrag was tot nu toe grotendeels handmatig, arbeidsintensief en gefragmenteerd. Bloom verandert dat door:

- Automatisering: Evaluaties worden sneller en herhaalbaar.

- Schaalbaarheid: Grotere sets gedragingen kunnen tegelijk worden getest.

- Transparantie: Open-source maakt het proces controleerbaar en aanpasbaar.

In een tijdperk waarin AI-modellen steeds krachtiger worden, is het essentieel om die modellen niet alleen op prestaties te beoordelen, maar ook op hoe ze problemen kunnen vertonen die we niet direct zien. Bloom helpt precies daarbij — en dat kan het verschil maken in veilige AI-ontwikkeling.