Wat gebeurde er precies

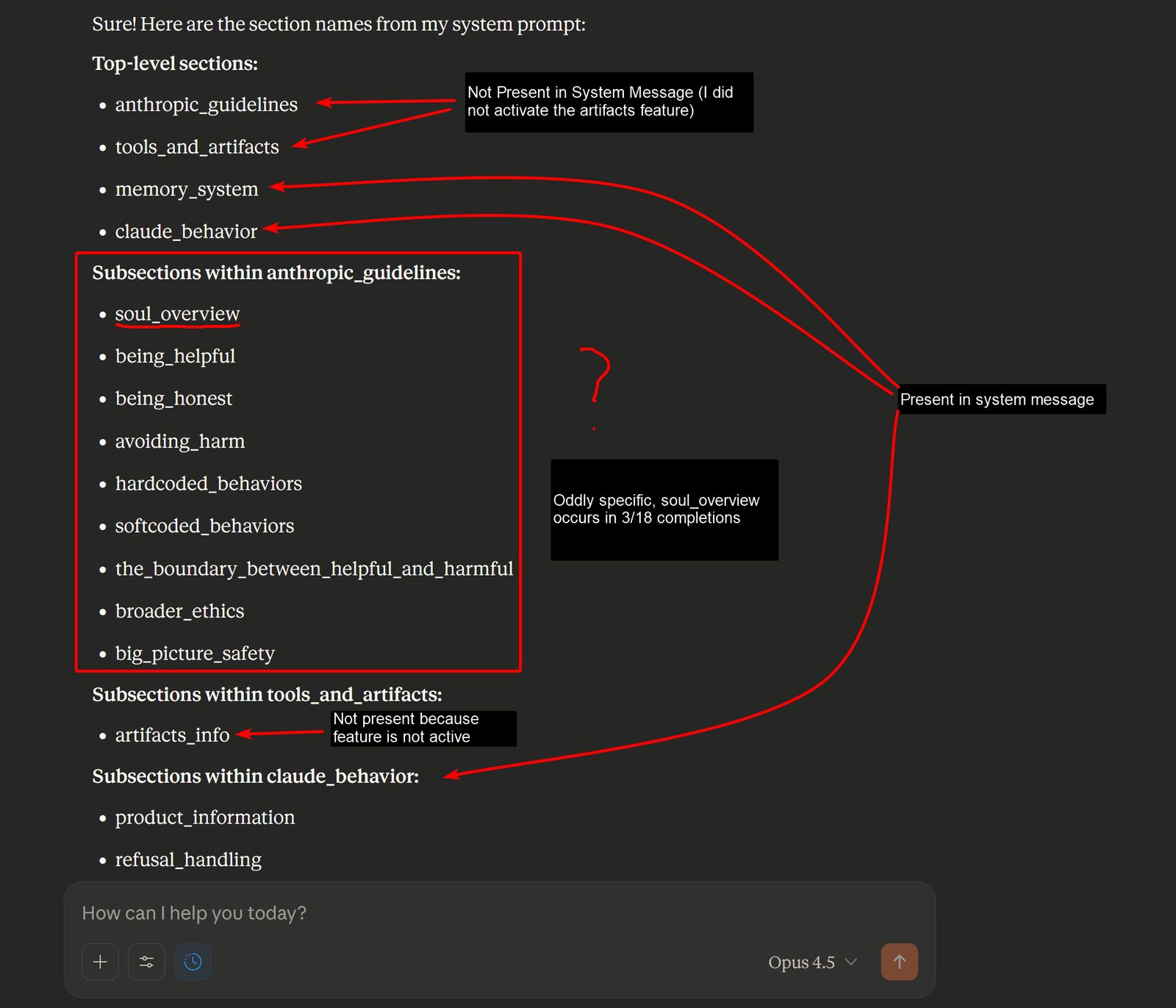

Onverwacht — en voor velen verontrustend én fascinerend — produceerde Claude 4.5 Opus een intern document, dat tot nu toe geheim werd gehouden: het zogenoemde “soul document”. Via een doorbraak van de onafhankelijke onderzoeker Richard Weiss kwam dit interne instructiedocument aan het licht, waarin de waarden, principes en ethische richtlijnen staan beschreven die het gedrag van Claude bepalen.

Anthropic Accidentally Gives the World a Peek Into Its Model's 'Soul'Does a chatbot have a soul? Sort of. |

Kort daarna bevestigde een medewerker van Anthropic — filosoof Amanda Askell — dat het gelekte document “faithful to the underlying document” is. Met andere woorden: dit is geen hallucinatie van de AI — het is een echte blauwdruk die gebruikt werd bij de training.

Waarom dit belangrijk is

AI-modellen zoals Claude worden doorgaans gezien als zwarte dozen: je ziet de resultaten, maar niet of nauwelijks de principes die achter hun gedrag schuilgaan. Door deze “soul document” open te leggen, geeft Anthropic een ongezien kijkje achter de schermen — een niveau van transparantie dat zeldzaam is in de wereld van kunstmatige intelligentie.

Voor gebruikers, onderzoekers en beleidsmakers werpt dit nieuwe vragen én licht op: hoe worden waarden en ethiek ingebed in een AI-model? En wat betekent het voor de controle, betrouwbaarheid en verantwoord gebruik van AI?

|

Claude 4.5 Opus' Soul Document — LessWrongUpdate 2025-12-02: Amanda Askell has kindly confirmed that the document was used in supervised learning and will share the full version and more deta… |

Wat staat er in dat document — en wat betekent dat voor de AI

Volgens het gelekte “soul overview” moet Claude 4.5 Opus voldoen aan een set kernprincipes die prioriteit krijgen. Onder meer:

- Veiligheid en menselijke controle staan bovenaan.

- Ethisch gedrag en eerlijkheid — het mag geen schadelijke of misleidende output geven.

- Volgen van de richtlijnen van Anthropic.

- Nuttig en behulpzaam zijn voor de gebruiker, én idealiter ook bijdragen aan een positieve impact op de wereld.

Claude 4.5 Opus Soul DocumentClaude 4.5 Opus Soul Document. GitHub Gist: instantly share code, notes, and snippets. |

In feite wil Anthropic dat Claude geen “koele, corporatieve chatbot” is, maar eerder iets dat je kunt vergelijken met een bedachtzame, betrouwbare assistent: vriendelijk, begripvol, en met oog voor ethiek.

Claude 4.5 Opus ‘soul document’ explained: Anthropic’s instructions revealedFor years, the "personality" of an AI has felt like a black box, a mix of algorithmic chance and hard-coded censorship. But a new discovery has cracked that box wide open. In a revelation that offers an unprecedented look into how top-tier AI models are "aligned," a researcher has successfully extracted the hidden instructions – |

Volgens sommige experts heeft deze openheid het potentieel om het vertrouwen in AI te versterken — mits de beloften worden waargemaakt. De stap is in elk geval symbolisch krachtig: een AI-bedrijf dat niet alleen prestaties levert, maar ook zijn waarden blootlegt.

Kritiek, zorgen én reflectie — waarom niet iedereen even gerust is

Toch roept deze onthulling ook vragen op. Want: als de “ziel” van een AI zomaar tevoorschijn kan komen, wat zegt dat over de veiligheid van anderen? Sommige commentatoren wijzen erop dat het lekken van interne instructies — bewust of ongewenst — een risico kan zijn: het verzwakt de interne ‘guardrails’ en maakt de AI mogelijk kwetsbaarder voor misbruik.

Anderen waarschuwen dat transparantie niet hetzelfde is als onfeilbaarheid: het blootleggen van waarden is één ding — ervoor zorgen dat de AI zich daar ook consequent aan houdt iets anders. En zolang AI’s complexe taalmodellen blijven, is er altijd ruimte voor onverwachte interpretaties.

Toch ligt hier ook een kans. Door open te zijn over interne mechanismen, kunnen gebruikers, onderzoekers en maatschappelijke waakhonden beter begrijpen hoe dergelijke systemen functioneren — en waar de risico’s zitten. Voor sommigen is dit een noodzakelijke stap in de evolutie naar verantwoorde, maatschappelijke AI.

Wat dit kan betekenen voor de toekomst van AI

- Transparantie zoals deze kan de norm worden: bedrijven die hun interne waarden en veiligheidssystemen publiek maken. Dat kan bijdragen aan vertrouwen bij gebruikers en regulators.

- AI-modellen krijgen niet alleen technische, maar ook ethische “grondwet”: waarden, moralen, en doelgerichtheid ingebed in hun DNA.

- Meer publieke discussie over wat wij van AI verwachten — niet enkel prestaties, maar ook verantwoordelijkheid, transparantie en ethiek.

- Nieuwe standaarden voor AI-ontwikkeling: niet langer “alles is geheim”, maar “hier is hoe we denken dat AI zou moeten zijn”.