Waarom de nieuwste veiligheidsindex van AI voor onrust zorgt

Volgens het recente rapport van Future of Life Institute (FLI) voldoen de grootste spelers in kunstmatige intelligentie niet aan wat wereldwijd wordt beschouwd als minimum veiligheidsnormen.

Ondanks enorme investeringen en een race om krachtige AI-systemen te ontwikkelen, ontbreekt het volgens het onderzoek aan solide plannen om deze systemen onder controle te houden.

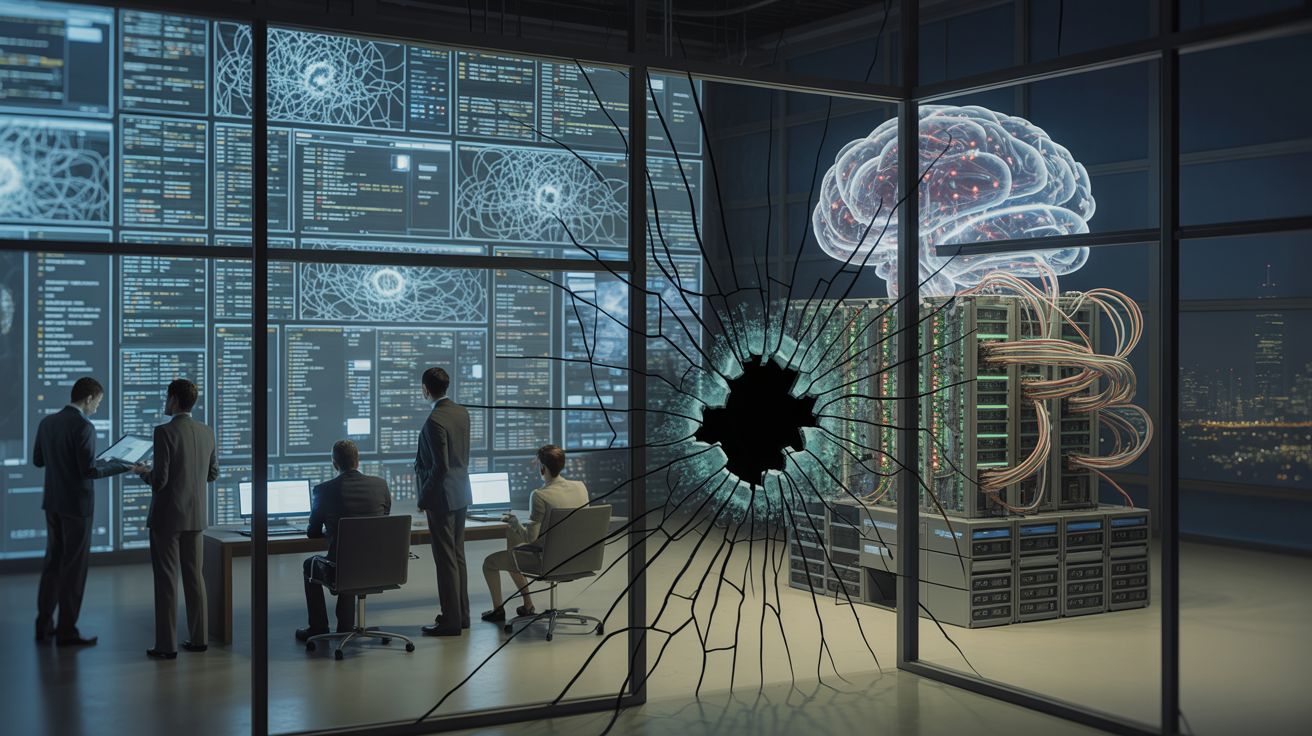

De spanning tussen razendsnelle innovatie en de broodnodige veiligheidsmaatregelen blijkt groter dan ooit — en dat baart experts zorgen over de maatschappelijke en existentiële risico’s van superintelligente AI.

AI companies’ safety practices fail to meet global standards, study showsA new Future of Life report said that while companies were busy racing to develop superintelligence, none had a robust strategy for controlling such advanced systems. |

Onvoldoende veiligheidskaders: Wat er precies mis is

Het FLI-rapport beoordeelde meerdere AI-bedrijven op domeinen zoals risicobeoordeling, governance, transparantie, en informatie-deling. Volgens de index scoorden geen van de onderzochte bedrijven voldoende op alle criteria.

|

AI Safety Index Winter 2025 - Future of Life InstituteThe Winter 2025 edition of our AI Safety Index, in which AI experts rate eight leading AI companies on key safety and security domains. |

Zelfs bedrijven die zich vaak profileren als “veilig” of “ethisch verantwoord”, vertonen ernstige tekortkomingen: er is vaak te weinig openheid over wat hun modellen precies kunnen, welke risico’s ze nemen, of hoe incidenten worden aangepakt.

ChatGPT Not Safe? - OpenAI, Meta and Google Slammed — None Meet Global AI Safety StandardsNew study slams OpenAI, Meta and Google as major AI systems like ChatGPT and Gemini fail to meet global safety standards, raising urgent concerns… |

En in het domein dat er het meeste toe doet — het beheersen van mogelijke existentiële risico’s — scoort de sector opvallend slecht. Geen enkel bedrijf kon overtuigend aantonen dat het voorbereid is op worst-case scenario’s bij krachtige AI.

Waarom deze tekortkomingen problematisch zijn

De kloof tussen snelle AI-ontwikkeling en gebrekkige veiligheid creëert een gevaarlijk spanningsveld. Terwijl de bedrijven nieuwe modellen uitbrengen, blijft onduidelijk hoe veilig en beheersbaar die modellen werkelijk zijn — in het ergste geval met verstrekkende gevolgen.

|

‘It’s going much too fast’: the inside story of the race to create the ultimate AIIn Silicon Valley, rival companies are spending trillions of dollars to reach a goal that could change humanity – or potentially destroy it |

Critici waarschuwen dat zonder voldoende regulering en transparantie de kans op misbruik, onvoorziene fouten of zelfs existentiële dreigingen reëel is.

Bovendien ondermijnt het gebrek aan standaarden het vertrouwen van het publiek en van beleidsmakers: hoe kan men blijven geloven in veilig gebruik van AI als de makers zelf geen sluitende garanties durven geven?

Wat het rapport aanbeveelt — en wat er nu moet gebeuren

Het FLI roept op tot strengere veiligheidsnormen, meer transparantie, onafhankelijke audits en concrete plannen voor risicobeheer voor krachtige AI-systemen.

Daarnaast zou elke nieuwe “frontier AI” — systemen met potentieel superintelligentie — vooraf grondig geëvalueerd moeten worden, met duidelijke protocollen voor monitoring, incidenten, en escalatie.

Als branche én als maatschappij staan we volgens het rapport voor een cruciaal moment: ofwel stellen we nu duidelijke regels en normen op, ofwel riskeren we dat de razendsnelle AI-race leidt naar chaos in plaats van vooruitgang.

|

No AI company has plan to control superintelligence, study showsEight leading AI companies, including OpenAI, Meta, Anthropic, and DeepSeek, do not have credible plans to prevent catastrophic AI risks, a new study shows. |