Hoe een Hollywood-kwestie het AI-landschap deed wankelen

Na het ontstaan van ophef over ongeautoriseerde deepfakes binnen Sora 2, is OpenAI met volle kracht overgegaan tot het aanscherpen van haar beveiligingsmechanismen. Een bekende acteur en zijn vakbond luidden de alarmbel — en die zorg leidde tot concrete veranderingen.

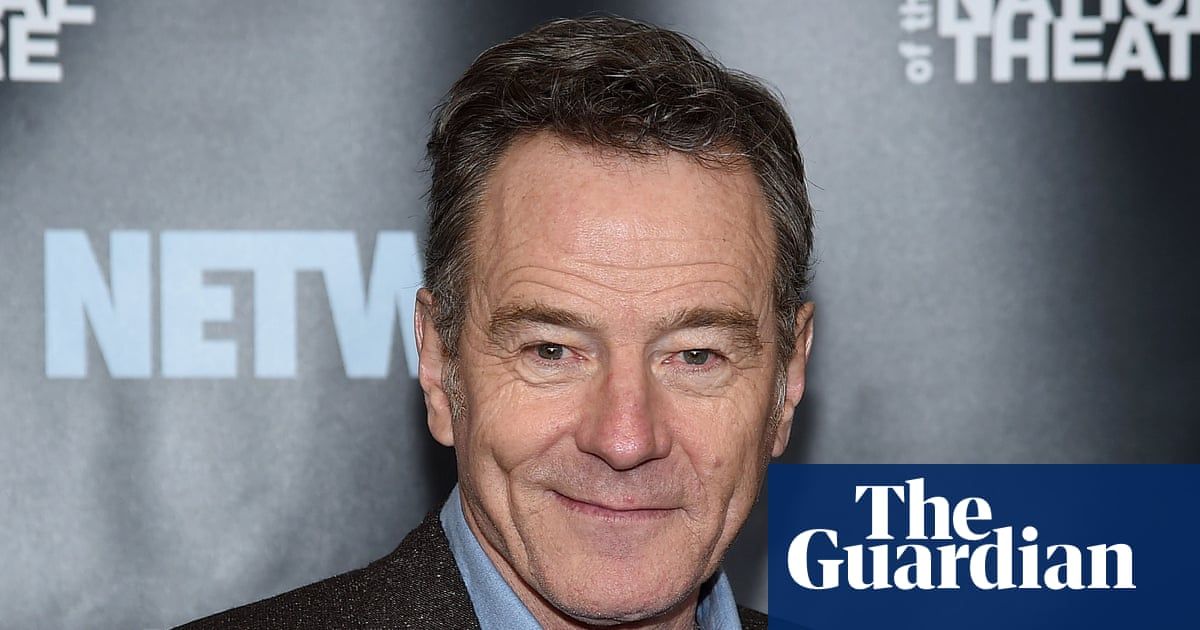

Bryan Cranston and SAG-AFTRA say OpenAI is taking their deepfake concerns seriouslyBryan Cranston discovered people were able to include him without his permission in videos generated by Sora 2. Now a joint statement with OpenAI and SAG-AFTRA says it’s “strengthening guardrails.” |

De aanleiding: Deepfakes zonder toestemming

Toen berichten de ronde deden dat gebruikers van Sora 2 audiovisueel materiaal met de stem en het uiterlijk van Bryan Cranston creëerden — zonder diens expliciete toestemming — trok de acteur aan de bel bij zijn vakbond SAG‑AFTRA en grote talentenbureaus. De bezorgdheid reikte verder dan één individu: het ging om het principe dat performers controle moeten houden over hoe hun stem of gelijkenis in de AI-wereld wordt gebruikt.

After deepfake drama, OpenAI and Bryan Cranston work out kinks for HollywoodOpenAI is working with Bryan Cranston and other Hollywood groups to limit deepfakes on its Sora 2 video app. |

OpenAI reageert: Opt-in, beleid en samenwerking

In reactie op de kritiek kondigde OpenAI aan dat het bedrijf haar opt-in-beleid inzake het gebruik van stem en gelijkenis versterkt heeft: niemand wordt voortaan gesimuleerd zonder voorafgaande toestemming. In een gezamenlijke verklaring met Cranston, SAG-AFTRA en grote Hollywood-bureaus zoals United Talent Agency (UTA) en Creative Artists Agency (CAA) werd toegezegd dat artiesten het recht hebben zelf te bepalen hoe en of zij worden gesimuleerd.

Cranston gaf aan dat hij “dankbaar is voor het beleid en de verbeterde maatregelen” en hoopte dat de sector in bredere zin de zeggenschap van artiesten respecteert.

|

Bryan Cranston thanks OpenAI for cracking down on Sora 2 deepfakesUsers of generative AI video app were able to recreate the Breaking Bad actor’s likeness without his consent, which OpenAI called ‘unintentional’ |

Een bredere kwestie: Historische figuren en AI-ethiek

Naast de kwestie met levende artiesten kwam ook het gebruik van historische figuren in beeld. Zo stelde OpenAI in overleg met het erfgoed van Martin Luther King Jr. dat Sora-generaties met zijn gelijkenis tijdelijk gepauzeerd worden, nadat er zogenaamde “respectloze” beelden opdoken. Dit wijst op de groeiende ethische, juridische én maatschappelijke dimensie van generatieve video-AI.

OpenAI Bans Martin Luther King Jr. Deepfakes After Users Create Racist Videos Using Newly-Released TechnologyOpenAI has banned the creation of 'disrespectful' deepfakes of Dr. Martin Luther King Jr. after several racist videos were created and circulated on the internet. |

Wat betekent dit voor de toekomst van AI-video?

Voor de gebruikers en makers van dergelijke technologieën is deze ontwikkeling een signaal: generatieve AI is niet louter een technische uitdaging, maar raakt aan rechten van beeld, stem en identiteit. Voor artiesten betekent dit meer zeggenschap. Voor technologiebedrijven betekent het: beleid opstellen, mechanismen inbouwen, én samenwerken met belanghebbenden.

Ook voor de kijker wordt het relevant: wanneer ziet men een echte acteerprestatie en wanneer is iemand via AI – en met of zonder toestemming? De lijn wordt dunner, en het vertrouwen hangt af van transparantie en regels.

Met de recente stap van OpenAI is een deel van de controverse niet opgelost — maar wel erkend. De beweging van “we kunnen dit zonder restricties doen” naar “we moeten overleg plegen en regels respecteren” is duidelijk zichtbaar. Of dit voldoende is om het vertrouwen terug te winnen, valt af te wachten. Maar één ding is helder: in het tijdperk van video-AI wordt toestemming geen bijzaak meer, maar kernvoorwaarde.